Парсер тематического контента по списку ключевых слов из поисковых систем

Содержание:

- Что такое семантическое ядро и почему оно так важно?

- Парсеры сайтов в зависимости от используемой технологии

- Как правильно парсить в Вордстат: обзор программ для анализа поисковой выдачи

- Программы для подбора и фильтрации запросов

- Сколько ключевых слов должно быть в семантике

- Что можно делать с помощью SQL запросов

- Зачем собирать частотности?

- 8 лайфхаков для ресторанного SMM

- Сервисы для анализа видимости конкурентов

- Как поменять валюту в «Стиме» на доллары?

- Парсеры сайтов по способу доступа к интерфейсу

- Сбор частотностей из Вордстата

- Как пользоваться парсером Wordstat от Click.ru

- Версии навигатора и системные требования для Андроид

- Три способа записи Windows на флешку

Что такое семантическое ядро и почему оно так важно?

Перечень ключевых слов и фраз, которые характеризуют направление и тематику сайта, называют семантическим ядром. Оно позволяет понять, пользуется ли спросом информация, товар, услуга, и выстроить грамотную структуру ресурса.

Термин «семантическое ядро» встречается часто. Что это такое? Поговорим о механизме работы поисковой системы. Мы вводим запрос (ключевое слово) и получаем перечень страниц, максимально релевантных нашему запросу и оптимизированных под него. Семантическим ядром считается список всех ключей, используемых для продвижения сайта.

Вам обязательно нужно знать и понимать, какие сведения и по каким запросам человек может найти на веб-ресурсе. Если вы не знаете этого, востребованным сайт никогда не станет. То есть SEO-продвижение невозможно без формирования семантического ядра.

Веб-сайт должен привлекать всю целевую аудиторию (ЦА). Для этого требуется:

- сбор полного семантического ядра. Помните, что на один запрос не делают одну страницу;

- кластеризация запросов. После сбора всех ключевых слов их нужно объединить в группы. В них может быть как 5, так и 25 ключей. Каждая группа предназначена для решения одной задачи;

- определение посадочной страницы. Одна страница — на одну группу. На сайте не должно быть двух страниц, решающих одну задачу.

Если вы заинтересованы в нормальном SEO-продвижении своего ресурса, соберите все возможные ключи. Возьмем сайт строительной компании. При выборе запросов мы понимаем, что жилье можно разбить по типам: дом, таунхаус, квартира и т. д. Соответственно подбираются следующие ключевые запросы: купить дом, купить квартиру, купить таунхаус, купить дом с ремонтом и пр.

Итак, мы разбили запросы на все способы и типы. Сейчас наша задача — разместить информацию. Необязательно помещать всё в меню веб-сайта. Лучше распределите данные по страницам разделов и подразделов, создайте блок фильтров. Так вы раскидаете все запросы по сайту и получите дополнительный трафик.

Поэтапное формирование семантического ядра выглядит так:

- Сбор ключевых запросов из многочисленных источников.

- Очистка ядра от неподходящих запросов.

- Объединение и группировка запросов.

- Формирование структуры сайта под данное ядро.

Залог качественного SEO-продвижения сайта заключается в грамотном формировании семантического ядра. Оно несет смысловую нагрузку вашего ресурса. Если человек по запросу не может получить полные (релевантные) сведения о вашем сайте, придется с ним (с сайтом) поработать.

Формирование качественного семантического ядра — долгий процесс. Кто-то предпочитает сбор семантики вручную, но большинство веб-студий делают это автоматизировано, используя специальные сервисы. Как подобрать запросы, что брать за основу? Поговорим об основных источниках ключевых слов.

В первую очередь нужно проанализировать информацию, товары или услуги, которые уже размещены или скоро появятся на сайте. Это — самое главное при работе с семантическим ядром. Ваша задача — максимально глубоко проанализировать проект и понять специфику ниши. У многих веб-специалистов нет возможности полностью изучить чужой бизнес, а потому в этом вопросе непременно нужно взаимодействовать с клиентом. Так, например, вы можете согласовать весь перечень поисковых фраз.

Яндекс-статистика запросов в поисковиках — прекрасное решение для оптимизаторов, позволяющее узнать, что пользователи ищут в Интернете. Всё, что вам нужно сделать — зайти на сервис wordstat.yandex.ru. Подобный инструмент есть и у Google: частота запросов www.google.ru/adwords/. Сервисы предназначены для использования контекстной рекламы, однако и для SEO-оптимизации тоже подходят.

Статистика сайта — отличный источник ключевых слов. Её также необходимо тщательно анализировать, особенно если у сайта уже есть хороший трафик. Накопленные данные позволяют оценить запросы и трафик поведения пользователей на странице (число просмотров, проведенное время, количество отказов).

Чтобы легко и быстро создать качественную структуру сайта, нужно проанализировать веб-ресурсы конкурентов. Необходимо лишь найти нескольких лидеров в вашем сегменте, у которых SEO-структура сформирована грамотно.

Далее есть несколько вариантов:

- анализ видимости конкурентов в поисковиках и получение списка их ключевых слов. Формирование семантического ядра на основе данных запросов или дополнение своего отсутствующими;

- сбор лучших решений из структуры нескольких сайтов конкурентов и создание своей идеальной.

Парсеры сайтов в зависимости от используемой технологии

Парсеры на основе Python и PHP

Такие парсеры создают программисты. Без специальных знаний сделать парсер самостоятельно не получится. На сегодня самый популярный язык для создания таких программ Python. Разработчикам, которые им владеют, могут быть полезны:

- библиотека Beautiful Soup;

- фреймворки с открытым исходным кодом Scrapy, Grab и другие.

Заказывать разработку парсера с нуля стоит только для нестандартных задач. Для большинства целей можно подобрать готовые решения.

Парсеры-расширения для браузеров

Парсить данные с сайтов могут бесплатные расширения для браузеров. Они извлекают данные из html-кода страниц при помощи языка запросов Xpath и выгружают их в удобные для дальнейшей работы форматы — XLSX, CSV, XML, JSON, Google Таблицы и другие. Так можно собрать цены, описания товаров, новости, отзывы и другие типы данных.

Примеры расширений для Chrome: Parsers, Scraper, Data Scraper, kimono.

Парсеры сайтов на основе Excel

В таких программах парсинг с последующей выгрузкой данных в форматы XLS* и CSV реализован при помощи макросов — специальных команд для автоматизации действий в MS Excel. Пример такой программы — ParserOK. Бесплатная пробная версия ограничена периодом в 10 дней.

Парсинг при помощи Google Таблиц

В Google Таблицах парсить данные можно при помощи двух функций — importxml и importhtml.

Функция IMPORTXML импортирует данные из источников формата XML, HTML, CSV, TSV, RSS, ATOM XML в ячейки таблицы при помощи запросов Xpath. Синтаксис функции:

IMPORTXML("https://site.com/catalog"; "//a/@href")

IMPORTXML(A2; B2)

Расшифруем: в первой строке содержится заключенный в кавычки url (обязательно с указанием протокола) и запрос Xpath.

Знание языка запросов Xpath для использования функции не обязательно, можно воспользоваться опцией браузера «копировать Xpath»:

Вторая строка указывает ячейки, куда будут импортированы данные.

IMPORTXML можно использовать для сбора метатегов и заголовков, количества внешних ссылок со страницы, количества товаров на странице категории и других данных.

У IMPORTHTML более узкий функционал — она импортирует данные из таблиц и списков, размещенных на странице сайта. Синтаксис функции:

IMPORTHTML("https://https://site.com/catalog/sweets"; "table"; 4)

IMPORTHTML(A2; B2; C2)

Расшифруем: в первой строке, как и в предыдущем случае, содержится заключенный в кавычки URL (обязательно с указанием протокола), затем параметр «table», если хотите получить данные из таблицы, или «list», если из списка. Числовое значение (индекс) означает порядковый номер таблицы или списка в html-коде страницы.

Как правильно парсить в Вордстат: обзор программ для анализа поисковой выдачи

Парсинг выдачи Яндекса – это процесс сбора поисковых запросов по заданной тематике (с помощью базовых маркеров). С Yandex Wordstat Assistant можно легко получить основную информацию для формирования семантического ядра – поисковые запросы, количество показов в месяц по каждой фразе, а также схожие по тематике слова, помогающие расширить охват целевой аудитории. Парсер Wordstat позволяет получить информацию по словам и по регионам, при этом система ориентируется именно на сайты.

Если хотите выполнить расширенный поиск, включающий не только Яндекс, но и социальные сети и другие поисковые системы, необходимо воспользоваться универсальными инструментами, например, A-Parser. Этот программный продукт отличается удобством в работе, но для эффективной работы с ним нужно купить прокси для парсинга.

В какой среде бы Вы ни работали, используйте универсальную схему сбора семантического ядра:

- формирование базового списка маркеров (запросов, однозначно релевантных сайту);

- сбор ключевых слов;

- удаление «мусора» — ненужных и случайно попавших в список запросов;

- кластеризация ключевиков по разделам сайта или тематикам.

Рассматриваем основной алгоритм работы с Вордстат и парсим Яндекс для сбора семантики на примере сайта агентства недвижимости. Допустим, нам нужно составить перечень релевантных ключевых запросов, соответствующих базовому маркеру «аренда квартир».

- Вводим базовый маркер в поисковую строку Яндекс Вордстат.

- При необходимости устанавливаем регион для более точного отбора запросов (например, Москва или Санкт-Петербург).

- В полученных результатах поиска используем значок «+» для выгрузки в таблицу Excel.

- Выгружаем полученные данные через буфер обмена (инструмент «A-Z»).

Совет! Обращайте внимание на подсказки типа «вместе с этим ищут» в соседнем поле выдачи результатов парсинга – это поможет вам охватить больше аудитории при составлении SEO-контента. Чтобы облегчить себе задачу по ручному парсингу, используйте операторы Яндекс

Например, поставив в конце поисковой фразы знак «!», вы зафиксируете окончание поискового запроса, и система будет искать слова именно в этой словоформе. Оператор «-» (минус) позволит убрать лишние слова, а квадратные скобки «» — зафиксировать порядок слов в запросе

Чтобы облегчить себе задачу по ручному парсингу, используйте операторы Яндекс. Например, поставив в конце поисковой фразы знак «!», вы зафиксируете окончание поискового запроса, и система будет искать слова именно в этой словоформе. Оператор «-» (минус) позволит убрать лишние слова, а квадратные скобки «» — зафиксировать порядок слов в запросе.

Программы для подбора и фильтрации запросов

- Key Collector — по признанию многих оптимизаторов — это лучшая программа для составления семантического ядра;

- Словоеб — младший брат Key Collector;

- Allsubmitter — многофункциональная программа, при помощи которой можно подбирать ключевые слова;

- Магадан — парсер ключевых слов Яндекс.Директа;

- Key Hunter — поиск и парсинг открытых Яндекс.Метрик;

- Metrica Spy — поиск и парсинг открытых Яндекс.Метрик, обсуждение;

- МегаЛемма — софт для морфологической обработки массивов ключевых слов и дальнейшей группировки;

- YWSCheck — парсер Яндекс.Вордстат и Яндекс.Директ;

- Yandex Key Checker — программа проверки ключей в Яндексе на частоту и конкурентность;

- Букварикс — программа для быстрого подбора ключевых слов, обсуждение;

- YaLiPa — парсер прямого эфира Яндекс;

- Kolyan — парсер прямого эфира Яндекс;

Сколько ключевых слов должно быть в семантике

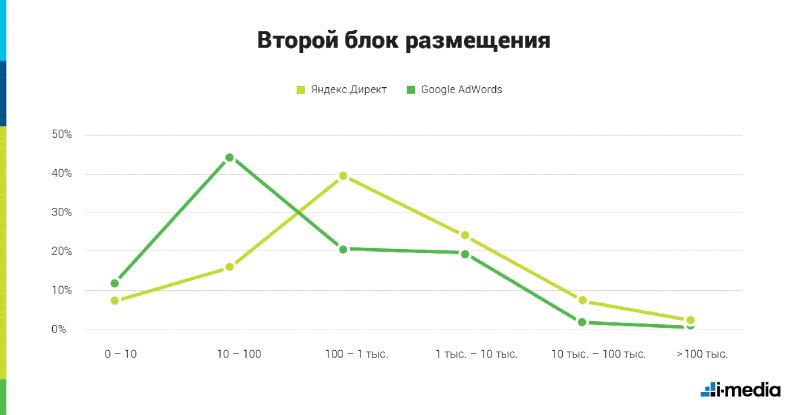

Несколько лет назад появились определенные обучающие курсы по контекстной рекламе, утверждающие, что большая СЯ на несколько тысяч или десяток тысяч ключевых слов дает больший охват и более низкую цену за клик. С тех пор существуют сторонники этого подхода и споры, хорошо это или нет.

Если коротко — это бесполезно, и даже вредно. Но в чем минусы кампаний с тысячами запросов?

- Подавляющее большинство таких запросов не дают ни показов, ни кликов. Даже если Wordstat на момент настройки кампаний показывает частотность >0, это всего лишь прогноз, и по факту 90-95% эти ключей не дадут ни одного показа.

- Из-за большого объема ключевых слов усложняется управление кампаниями, статистика по кликам и конверсиям «размазывается» по разным ключам.

- Может потеряться часть кликов. Большинству таким низкочастотным запросам присваивается статус «мало запросов» в Google и «мало показов» в Яндексе, и даже если есть по ним 1-2 показа в месяц, из-за этих статусов реклама не покажется. В Google с этим ничего не поделать и потеря кликов обеспечена. В Яндекс бороться с «мало показов» можно, но это требует определенных трудозатрат, от которых не будет никакой пользы. Большинство низкочастотников настолько длинные, что в заголовок объявления их не вставить, а в противном случае пользы от их добавления практически нет.

- При использовании семантического ядра на тысячи запросов тексты объявлений обычно генерируются автоматически, в следствие чего часть из них получается нечитабельным набором слов.

В наших кампаниях, в зависимости от ниши, используется примерно по 20-500 ключевиков. Этого достаточно, чтобы охватить целевую аудиторию и получать клики по минимально возможной цене. Больше (несколько тысяч или десятков тысяч) бывает только у клиентов с большим ассортиментом товаров или большим количеством услуг.

Что можно делать с помощью SQL запросов

Зачем собирать частотности?

Есть три основных причины:

1. Частотность нужна для прогнозирования трафика. Данные о том, сколько раз пользователи ищут определенный запрос, позволяют примерно спрогнозировать количество переходов, которые сайт получит в зависимости от позиции в поиске.

Как это выглядит на практике?

- перед началом продвижения сайта вы собираете список запросов;

- чтобы оценить трафик по одной из фраз, определяете ее частотность («заказать диван в Новосибирске» — 1839);

- узнаете показатель CTR для разных позиций на странице выдачи;

- на основе этих данных прогнозируете объем трафика, который можно получить при ранжировании сайта в ТОП-10.

Формула для расчета объема трафика:

Частотность * CTR/100 = Прогнозируемый объем трафика.

Например, если вторая или третья позиция выдачи имеет CTR 25%, то вы можете рассчитывать примерно на такой объем трафика:

1839*25/100 = 459.

2. Фильтрация «мусорных» запросов — фраз с околонулевой частотностью. Под них нет смысла оптимизировать страницы сайта.

В каких случаях фразы можно считать мусорными?

Нет единого стандарта, нужно смотреть по тематике:

- Для узких тематик с небольшими объемами трафика можно оставлять и фразы с частотностью 1. Каждый пользователь на вес золота, поэтому стоит использовать все доступные запросы.

- Для магазинов, работающих в сегменте масс-маркета, стоит брать в работу запросы с частотностью от 5. Все, что ниже — можно смело удалять из ядра.

- Нижняя планка частотности запросов для информационных сайтов — 10-20.

Не стоит сразу удалять все запросы с небольшой частотностью. Проверьте, нет ли там низкочастотных запросов, по которым приходят «теплые» клиенты.

3. Частотность помогает правильно распределить запросы на странице. ВЧ-запросы размещают в элементы Title и H1. Фразы с меньшей частотностью используют для создания разделов и подразделов.

8 лайфхаков для ресторанного SMM

Сервисы для анализа видимости конкурентов

- semrush.com — сервис анализа ключевых слов конкурентов;

- spywords.ru — анализ поисковых запросов конкурентов в контекстной рекламе и поиске;

- prodvigator.ua — сервис для анализа конкурентов и подбора ключевых фраз;

- serp.advse.ru — сервис анализа ключевых слов конкурентов;

- wordstat.io — инструмент для анализа конкурентов, мониторинга выдачи и рекламы;

- advodka.com — анализ видимости в Яндекс и Google

- megaindex.ru — бесплатный инструмент по определению видимости сайта

- keys.so — платный инструмент для анализа ключевых слов конкурентов.

- topvisor.ru — парсинг запросов из разных источников (Яндекс, Google, Mail.Ru)

Как поменять валюту в «Стиме» на доллары?

Парсеры сайтов по способу доступа к интерфейсу

Облачные парсеры

Облачные сервисы не требуют установки на ПК. Все данные хранятся на серверах разработчиков, вы скачиваете только результат парсинга. Доступ к программному обеспечению осуществляется через веб-интерфейс или по API.

Примеры облачных парсеров с англоязычным интерфейсом:

- http://import.io/,

- Mozenda (есть также ПО для установки на компьютер),

- Octoparce,

- ParseHub.

Примеры облачных парсеров с русскоязычным интерфейсом:

- Xmldatafeed,

- Диггернаут,

- Catalogloader.

У всех сервисов есть бесплатная версия, которая ограничена или периодом использования, или количеством страниц для сканирования.

Программы-парсеры

ПO для парсинга устанавливается на компьютер. В подавляющем большинстве случаев такие парсеры совместимы с ОС Windows. Обладателям mac OS можно запускать их с виртуальных машин. Некоторые программы могут работать со съемных носителей.

Примеры парсеров-программ:

- ParserOK,

- Datacol,

- SEO-парсеры — Screaming Frog, ComparseR, Netpeak Spider и другие.

Сбор частотностей из Вордстата

Он нужен, чтобы узнать точное количество запросов по ключам.

Нажмите кнопку с таким значком:

Программа предлагает разные варианты – собрать:

- Все виды частотностей

- Базовые виды частотности

- Частотности фраз в кавычках (то есть в фразовом соответствии)

- Частотности фраз в точном соответствии (конкретно по данном словоформе).

Выберите последний вариант и дождитесь окончания сбора данных. Результат будет выглядеть примерно так (на том же примере с пиццей):

Далее вы можете сразу очистить результаты от явно нецелевых запросов прямо в программе Словоеб, или оставить это на потом – удалить мусорные фразы из экспортированного Excel-файла.

Итак, сбор семантики завершен. Результаты парсинга можно сохранить на свой компьютер для дальнейшего использования в рекламных кампаниях.

Кликните кнопку экспорта:

Допустим, вы в самом начале настройки выбрали для экспорта формат csv – на выходе получаете CSV-файл с семантикой.

Если вы распределяли ключи по группам, в этом файле каждый лист соответствует отдельной группе.

Вот и всё, что нужно знать про Словоеб и как с ним работать.

Как пользоваться парсером Wordstat от Click.ru

В числе инструментов Click.ru как раз есть функциональный и недорогой парсер Wordstat. Он быстро выдает частотность даже по большому списку запросов. При этом учитывает типы соответствия и региональность. Еще не требует капчу и прокси-серверы, а отчеты позволяет выгружать в Excel и хранить в «облаке».

Для начала работы зарегистрируйтесь в системе Click.ru. После входа в свой аккаунт на главной странице выберите раздел «Парсер частоты Wordstat» и приступайте к работе.

Для начала парсинга перейдите в соответствующий раздел

Как работать с парсером Wordstat после регистрации в Click.ru:

Загрузите список запросов.

Есть два способа: скопировать и вставить ключи в специальное поле или же загрузить XLSX-файл с ними.

При копировании списка учитывайте, что каждый ключ должен идти с новой строки. А в эксель-файле смотрите, чтобы не было вспомогательной информации (названий столбцов, лишних цифр и т. д.). Система берет запросы из первого листа .XLSX по принципу «одна ячейка – один ключ».

Этап загрузки запросов

Выберите регионы.

В системе доступны все регионы Яндекса. Можно посчитать общую частотность по нескольким регионам или получить статистику отдельно по каждому.

Разделять регионы в отчете нужно, если вы планируете продвигать бизнес отдельными региональными поддоменами и посадочными страницами, привязанными к географии. В остальных случаях галочка не ставится.

Выбираем регионы

Укажите тип соответствия.

Широкое соответствие – когда фразы пробиваются как есть – часто показывает обманчивую частотность. Все из-за того, что учитываются все вложенные ключи, в том числе нерелевантные (как в примере с игрушками). То есть всегда лучше перепроверять частоту запроса с помощью специальных операторов.

Кавычки позволяют уточнять статистику по конкретной фразе, без учета вложенных ключей.

Пример

| скачать видео бесплатно – 1 111 285 показов | “скачать видео бесплатно” – 8 493 показа |

Кавычки с восклицательными знаками показывают частотность по заданным словоформам.

Пример

| “!купить !телефон” – 37 909 показов | “!купить !телефоны” – 2 798 показов |

Квадратные скобки – фиксируют порядок слов, что особенно важно в туристическом бизнесе

Пример

| – 4 213 показов | – 1 814 показов |

Все варианты типов соответствия

Запустите проверку.

Время сбора частотностей зависит от количества запросов, регионов и типов соответствия. Если запросов меньше 1 000, процесс займет 1–2 минуты.

Результат будет доступен в списке задач. Можно открыть отчет в браузере или скачать его в формате XLSX.

Здесь будут появляться отчеты со статистикой