Что такое индексация и как проиндексировать сайт?

Содержание:

- Что необходимо сделать для начала индексации нового сайта

- Проверка индексации страниц сайта в Google

- Особенности индексирования сайтов с разными технологиями

- Как ускорить индексацию сайта платно и бесплатно

- Самостоятельное добавление сайта

- Как происходит индексация сайта в Google

- Используем панель Вебмастера

- Синхронизируем аккаунты Инстаграм и Фейсбук: обычные и для бизнеса

- Приведем пример удачной индексации

- Индексация в Google и Yandex

- Libre Office

- Как управлять поисковым роботом

- Индексация сайта как Интернет ресурса

- Различия индексации сайта в Google и «Яндексе»

Что необходимо сделать для начала индексации нового сайта

Чтобы поисковые роботы начали индексировать сайт, необходимо:

- Убедиться, что индексация открыта в robots.txt.

Это довольно распространенная ошибка: новый сайт не открывают для индексирования в robots.txt. Эта опция по умолчанию присутствует в большинстве систем управления ресурсами.

Закрытый от индексации сайт можно узнать по наличию звездочки:

Удаление этого значка делает сайт доступным для поисковых роботов.

Строка Disallow позволяет скрыть служебные разделы и прочие страницы, которые не требуют индексации.

- Добавить сайт в поисковые системы.

Проще всего «открыть» сайт для поисковых систем – это добавление через формы, а также в Google webmaster tools и «Яндекс.Вебмастере».

- Поставить ссылки с других сайтов.

На новый сайт должны вести индексируемые ссылки с других ресурсов. При наличии уже работающего собственного сайта переходы обеспечиваются с него, а при создании самого первого ссылки покупаются на специальных биржах. Оптимальным вариантом будет задействование авторитетных ресурсов, которые регулярно обновляются.

Отличной индексацией могут похвастаться блоги и сайты СМИ. Ссылочные биржи – простой и надежный способ разместить на этих ресурсах ссылки, ведущие на новый сайт, тем самым способствуя его изучению поисковиками и включению в индекс.

- Ссылки из социальных сетей.

Положительно отражаются на индексации сайта прямые ссылки из соцсетей. Twitter, Facebook, Google Plus, YouTube – эти и многие другие площадки помогут «познакомить» поисковые системы с вашим ресурсом.

Для ожидаемого результата необходимо следить, чтобы ссылки были обязательно прямыми. Редирект, который задействован в социальной сети «Вконтакте», не позволит добиться индексации сайта.

- Добавление сайта в социальные закладки.

Ситуация со ссылками из социальных закладок, которые еще несколько лет назад были отличным вариантом, сегодня слегка изменилась, но не для всех сервисов.

К социальным закладкам относятся такие сайты, как: bobrdobr.ru, memori.qip.ru, moemesto.ru, mister-wong.ru и сотни подобных им. Их несомненное достоинство в том, что благодаря им ваш ресурс будет быстро обнаружен поисковыми роботами.

Конечно, индексация сайта в поисковиках будет максимально успешной, если одновременно применять все способы.

Оптимизация сайта – очень важный этап раскрутки, но все меры по продвижению не принесут успеха, если ресурс не индексируется поисковыми системами, поэтому этот вопрос необходимо решить в первую очередь.

Вас также может заинтересовать: Сайт закрыт от индексации: это не повод для паники

Проверка индексации страниц сайта в Google

В Google работает только один оператор site, показывающий число проиндексированных страниц. Отличие Гугла от Яндекса заключается в том, что у Google есть основной и дополнительный индекс. Что каждый из них представляет читайте ниже.

Дополнительный индекс Google. Сеошники дали ему название «сопли», так как в нем находятся все страницы и документы, которые роботу Google удалось найти на Вашем сайте. Сюда можно отнести страницы сайта, которые запрещены для показа в основной выдаче: это могут быть дублирующие страницы сайта, которые создаются из-за новых комментариев, страницы постраничной навигации.

Основной индекс Google. В нем находятся все проиндексированные страницы Вашего сайта, которые показываются пользователям интернета в результатах выдачи по искомым ключевым фразам. Чтобы определить какие страницы сайта попали в основной индекс, добавьте к оператору символ &, как показано на картинке ниже. Символ & находится на клавиатуре на кнопке с цифрой 7.

На первой картинке показано 5 480 результатов, а на второй — 468. По своей неопытности, я сразу после создания своего блога не закрыла от индексации ненужные разделы в файле robots.txt. В то время, когда я создавала блог информации было не много на тему создания сайтов, приходилось все делать «методом проб и ошибок». Это сейчас уже и готовые примеры файла robots.txt есть в сети и рекомендации по его настройке. Поэтому мусорных страниц, которые не несут никакой информации и пользы, Гугл успел насобирать до 5 000 штук.

Полную картину того, какая индексация сайта в поисковых системах, именно у Вашего сайта покажет панель инструментов для веб-мастеров Яндекса и Гугла. Если Вы еще не подключили сайта ни к одной из этих панелей, скорее сделайте это. Помогут Вам в этом эти статьи-инструкции:

- Инструменты Google Tools https://inetsovety.ru/google-search-console/

- Яндекс Вебмастер https://inetsovety.ru/yandex-webmaster/

В инструментах Гугла в пункте Индекс Google, Вам будет показан график с изменением количества страниц по датам. Главное, чтобы он был ровным, а не такой, как у меня :):

На главной странице Яндекс Вебмастера, Вы увидите численное значение проиндексированных страниц, а кликнув по значку графика напротив строки «Страниц в поиске», сможете посмотреть график за последние 3 месяца. А самый простой способ проверить индексацию сайта и посмотреть какое количество страниц в индексе Яндекса и Гугла — воспользоваться одним из следующих бесплатных сервисов:

- плагин RDS bar. Устанавливается, как дополнение, для любого браузера. И позволяет в несколько кликов посмотреть информацию по основным параметрам для любого сайта.

- инструменты для вебмастера . В этом сервисе мне больше всего нравится графическое представление статистики по изменению показателей сайта и по индексации сайта в Яндексе и Гугле

Особенности индексирования сайтов с разными технологиями

Ajax

Сегодня все чаще встречаются JS-сайты с динамическим контентом ― они быстро загружаются и удобны для пользователей. Одно из основных отличий таких сайтов на AJAX — все содержимое подгружается одним сплошным скриптом, без разделения на страницы с URL. Вместо этого ― страницы с хештегом #, которые не индексируются поисковиками. Как следствие — вместо URL типа https://mywebsite.ru/#example поисковый робот обращается к https://mywebsite.ru. И так для каждого найденного URL с #.

В этом и кроется сложность для поисковых роботов, потому что они просто не могут «считать» весь контент сайта. Для поисковиков хороший сайт ― это текст, который они могут просканировать, а не интерактивное веб-приложение, которое игнорирует природу привычных нам веб-страниц с URL.

Буквально пять лет назад сеошники могли только мечтать о том, чтобы продвинуть такой сайт в поиске. Но все меняется. Уже сейчас в справочной информации и Google, и Яндекс есть данные о том, что нужно для индексации AJAX-сайтов и как избежать ошибок в этом процессе.

Сайты на AJAX с 2019 года рендерятся Google напрямую — это значит, что поисковые роботы сканируют и обрабатывают #! URL как есть, имитируя поведение человека. Поэтому вебмастерам больше не нужно прописывать HTML-версию страницы.

Но здесь важно проверить, не закрыты ли скрипты со стилями в вашем robots.txt. Если они закрыты, обязательно откройте их для индексирования поисковыми роботам

Для этого в robots.txt нужно добавить такие команды:

Поисковые роботы Яндекса тоже могут индексировать сайты на AJAX, но при одном условии ― если у каждой страницы сайта есть HTML-версия. В справочнике Яндекса можно узнать подробнее, как сообщить роботу об HTML-версии страницы.

Флеш-контент

С помощью технологии Flash, которая принадлежит компании Adobe, на страницах сайта можно создавать интерактивный контент с анимацией и звуком. За 20 лет своего развития у технологии было выявлено массу недостатков, включая большую нагрузку на процессор, ошибки в работе флеш-плеера и ошибки в индексировании контента поисковиками.

В 2019 году Google перестал индексировать флеш-контент, ознаменовав тем самым конец целой эпохи. Поисковые роботы Яндекса индексируют только тот текст во Flash-документах, который размещен в таких блоках: DefineText; DefineText2; DefineEditText; Metadata.

Поэтому не удивительно, что поисковики предлагают не использовать Flash на ваших сайтах. Если же дизайн сайта выполнен с применением этой технологии, сделайте и текстовую версию сайта. Она будет полезна как пользователям, у которых не установлена совсем или установлена устаревшая программа отображения Flash, пользователям мобильных устройств (они не отображают flash-контент), так и поисковым роботам Яндекса.

Фреймы

Фрейм это HTML-документ, который не содержит собственного контента, а состоит из разных областей ― каждая с отдельной веб-страницей. Также у него отсутствует элемент BODY.

Как результат, поисковым роботам просто негде искать полезный контент для сканирования. Страницы с фреймами индексируются очень медленно и с ошибками.

Вот что известно от самих поисковиков: Яндекс индексирует контент внутри тегов <frameset> и <frame> и не индексирует документы, подгружаемые в тег <iframe>. А вот Google может индексировать контент внутри встроенного фрейма iframe. Именно iframe поддерживается современными технологиями, так как он позволяет встраивать фреймы на страницы без применения тега <iframe>.

А вот теги <frame>, <noframes>, <frameset> устарели и уже не поддерживаются в HTML5, поэтому и не рекомендуется использовать их на сайтах. Ведь даже если страницы с фреймами будут проиндексированы, то трудностей в их продвижении вам все равно не избежать.

Как ускорить индексацию сайта платно и бесплатно

Ускорение процесса внесения в базу данных ресурса позволяет улучшить его показатели в поисковой выдаче. Существуют платные и бесплатные способы. Для бесплатного ускорения требуется провести внутреннюю оптимизацию ресурса. Потребуется выполнение следующих действий:

- создание карты сайта. Она формируется в виде файла с расширением XML. Для облегчения процесса можно воспользоваться бесплатными генераторами;

- организация RSS-трансляции материалов, что позволит размещать анонсы на сторонних ресурсах;

- опубликование статей в каталогах;

- проведение грамотной внутренней перелинковки;

- нужно избегать выпадающих меню и применения flash фрэймов;

- выбор правильного доменного имени. Поисковые системы «не любят» зоны типа .inf или .org.

Для проведения платной индексации сайтов в РФ можно воспользоваться специализированными сервисами по закупке ссылок или размещением собственных статей с кросслинками на индексируемый ресурс на биржах с аналогичным материалом.

Самостоятельное добавление сайта

Поскольку индексация сайта достаточно небыстрый процесс, то для его ускорения можно использовать ручное занесение страницы в индекс поисковых систем. Предварительно следует осуществить подготовку сайта к проведению его индексирования. Необходимо размещать на индексацию в Яндекс или Гугл законченные страницы. Иначе роботизированная система неправильно проведет их определение, что негативно скажется на рейтинге страницы или ранжировании ресурса в поисковой выдаче.

При подготовке сайта к индексации в Google или Яндексе следует обращать внимание на следующие моменты:

- оптимальным является создание страниц на HTML, поскольку применение flash файлов имеет ограничение по индексированию;

- на применение Java скриптов также накладываются запреты по индексации роботами, поэтому важную информацию следует дублировать текстовыми ссылками;

- предварительно проверяются внутренние ссылки на работоспособность, поскольку битая перелинковка может стать причиной того, что индексация сайта будет некорректной;

- продуманная структура и помещение второстепенных сведений вниз страницы или их сокрытие от ботов тэгами также позволит улучшить индексацию сайта в поисковых системах.

Самостоятельно добавление ресурса в индекс можно осуществить бесплатно при помощи сервисов для индексирования, которые предлагают все крупные поисковики:

- Яндекс. Для внесения собственного ресурса в популярный поисковик, требуется вручную указать URL адрес в сервисе Яндекс.Вебмастер.

- . Чтобы добавить сайт на индексацию в Гугле требуется зайти на search console (https://www.google.com/webmasters/tools/submit-url?pli=1) и ввести URL адрес добавляемого ресурса.

- Rambler. Поисковая система не имеет собственной формы, поэтому для ручного добавления страницы ее следует внести в сервис от Яндекса.

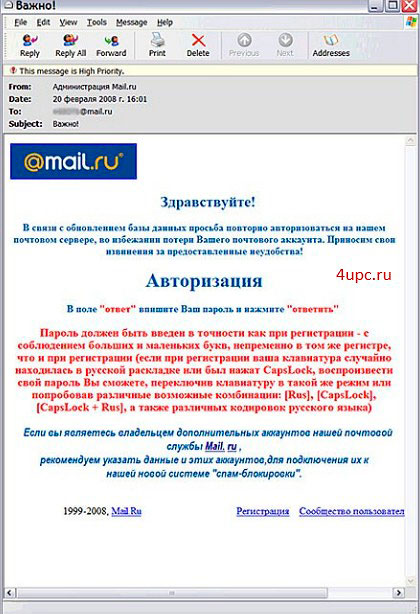

- Mail. Еще одна крупная система, которая позволяет проводить процесс индексирования через кабинет Вебмастера. Для полноценного использования сервиса требуется авторизация.

Как происходит индексация сайта в Google

Скорость индексации разных онлайн-площадок в Google различается. Существует ряд факторов, от которых зависит, как быстро роботы поисковой системы посетят веб-площадку и сколько времени понадобится для внесения в информационную базу обнаруженных изменений. К примеру, новостные ресурсы индексируются быстроботами с интервалом в несколько часов. Есть несколько вариантов добавления онлайн-ресурса в «Гугл». Один из таких способов связан с размещением ссылок на проиндексированных страницах.

После посещения интернет-площадки роботы поисковой системы анализируют всю необходимую информацию и вносят ее в базу данных. Затем происходит ранжирование и определение авторитетности сайта (сортировка по установленным критериям – PageRank). Эти показатели рассчитываются исходя из количества и качества ссылок, которые ведут на него с других веб-страниц. Чем больше ссылочной массы, тем выше PageRank.

Рассмотрим основные факторы, влияющие на индексацию сайта в Google:

- посещаемость;

- релевантность контента (соответствие информации, представленной на сайте, запросам, которые интернет-пользователи вносят в поисковик) обеспечивается с помощью определенного количества ключевых слов в контенте и метатегах;

- внутренняя оптимизация страниц сайта.

Показатели авторитетности интернет-страниц могут находиться в пределах от 0 до 10. У лучших ресурсов PageRank составляет 4–5 пунктов. По шкале авторитетности сам «Гугл» имеет показатель в 10 пунктов. В настоящее время отключен тулбарный показатель PR.

Нужно учитывать, что страницы блогов, сайтов и других ресурсов, имеющие более высокие индексы авторитетности, в выдаче «Гугла» располагаются выше своих конкурентов. При этом каждая из них имеет свой собственный показатель PageRank, поэтому у всех страниц место в выдаче может быть разным.

Индексация осуществляется с помощью Googlebot, который и осуществляет сканирование.

Что такое «Гуглбот»? В чем отличие сканирования от индексирования веб-страниц? Как эти процессы могут ускорить попадание страниц сайта в выдачу «Гугла»? Ответы на эти вопросы приведены ниже:

- Googlebot – специальная программа поисковой системы «Гугл», осуществляющая сбор информации в сети Интернет и сканирование веб-страниц с последующим их размещением в поисковой выдаче.

- Сканирование старых и новых страниц сайтов, которое осуществляется программой Googlebot, необходимо для поиска новой и измененной информации, передаваемой поисковой системе «Гугл». На этот процесс значительное влияние оказывают ссылки.

- После обработки информации, собранной гугл-ботами во время сканирования интернет-страниц, происходит их индексация. При условии, что размещенный контент соответствует качественным требованиям, он добавляется в индекс. В процессе индексации информации, размещенной на страницах, обязательно проводится рассмотрение ключевых слов, анализ alt-тегов и «тайтлов».

Остается только уточнить, как же программа Googlebot обнаруживает новый контент или обновление данных. Этот процесс включает анализ собранной информации об интернет-страницах, проиндексированных «Гуглом», и данных карты сайта, которая размещена его администратором. Далее рассмотрим, что нужно сделать, чтобы пройти индексацию.

Используем панель Вебмастера

Каждая поисковая система имеет свою панель инструментов, специально предназначенную для вебмастеров. С помощью этой панели можно увидеть общее количество проиндексированных страниц. Рассмотрим на примере самых популярных ПС (Яндекс и Google), как выполнять такую проверку.

Чтобы использовать панель инструментов Яндекс в данном контексте, нужно завести аккаунт (если его еще нет), зайти в панель и добавить в нее свой сайт. Там будет показано общее количество страниц, которые уже проиндексированы.

Для использования панели инструментов Google также нужно обзавестись аккаунтом, чтобы иметь возможность зайти в панель. В нее нужно добавить свой сайт и зайти на вкладку «Состояние / Статус индексирования». Здесь также будет показано количество проиндексированных страниц.

Нередко можно заметить, что панель Вебмастера Google может показать значительно большее количество проиндексированных страниц, чем панель инструментов Яндекс. Представим, что на сайте 70 уникальных страниц, которые проиндексировались. И, скажем, Яндекс насчитал приблизительно такое количество ссылок, а Гугл, например, 210. Получается, что Яндекс показал правильное число, а Гугл в 3 раза больше. Так в чем же дело? А дело в дублях страниц, генерируемых движком WordPress. Такие дубли поисковикам не по душе. Использование robots.txt позволяет игнорировать индексацию дублей страниц поисковыми системами. И если на Яндекс это действует, то с Гуглом в этом плане могут возникать проблемы, так как он может действовать по своему усмотрению.

Есть также специальный сервис Pr-cy.ru, позволяющий получить вебмастерам различные данные по сайтам – в том числе, число страниц, проиндексированных в Гугле и Яндексе. Чтобы узнать эту информацию, нужно посмотреть на две нижние колонки соответствующих поисковых систем.

Что помогает ускорить индексацию сайта

Чтобы страницы быстрее индексировались, нужно придерживаться главных правил:

Регулярное размещение уникальных и оптимизированных статей. Поисковый робот возьмет себе за привычку регулярно посещать тот сайт, на котором с определенной периодичностью размещается качественный, полезный и интересный контент.

Анонсирование о размещении нового контента или полезных обновлениях на сайте через социальные сети. После того, как появилась статья, можно самостоятельно сообщить об этом в социальную сеть с помощью кнопки retweet. Поисковый бот отметит это и зайдет на сайт через социальную сеть значительно быстрее.

Поисковому роботу гораздо проще найти конкретную страницу с помощью ссылки, имеющейся на вашем сайте

То есть, не стоит забывать о важности внутренней перелинковки.

Добавив xml-карту в панель вебмастера, мы даем возможность поисковому боту пройти по ней. Также ее нужно добавить в robots.txt

Полезна и карта сайта (карта для человека), по которой бот отыщет все страницы сайта.

В материале мы рассмотрели основные способы, позволяющие проверить, попали ли страницы сайта в индекс различных поисковых систем. Некоторые из них более эффективные, а какие-то – менее, но каждый из них имеет право на существование и использование.

Читайте далее:

Методы ускорения индексации сайта в яндексе

Seo — проверка индексации текста и веса ссылок тест

Быстрая индексация сайта в Гугле

Индексация ссылок

Проверить картинки на уникальность

Как скрыть персональные данные в поисковых системах?

Синхронизируем аккаунты Инстаграм и Фейсбук: обычные и для бизнеса

Приведем пример удачной индексации

Неделю назад на одном из сайтов появилась статья про ружье ВПО-213. Информации об этом ружье в Сети практически не было — оно еще не появилось в продаже. Была только короткая презентация в видео на Ютубе. Соответственно, текст был полностью уникальным и чуть ли не единственным в интернете на эту тему. В районе полуночи текст был опубликован на сайте (даже не на главной странице!) и в течение короткого времени проиндексирован. В половине десятого утра следующего дня статья была на третьем месте в поисковой выдаче Яндекса. В 9.50 она стала первой и держит эти позиции до сих пор.

Пример удачной индексации

Читайте нашу азбуку интернет-маркетинга, делитесь важным с друзьями!

Индексация в Google и Yandex

Google и Яндекс считаются двумя наиболее массовыми в нашей стране поисковиками. Эти сервисы позволяют самостоятельно добавлять новые сайты в свой индекс. Для этого можно использовать такие инструменты:

- Заполнение формы «Добавить URL» при помощи инструментов Яндекс-Вебмастер или Google Search Console;

- Размещение ссылки на новую страницу на уже проиндексированном веб-сайте, через который бот Яндекса или Гугла попадет на новую страницу. Этот способ считается самым правильным, поскольку робот в таком случае считает информацию вашего сайта интересной и привлекательной для пользователей.

В любом случае, длительность индексации сайта составляет от нескольких минут до нескольких недель, в среднем 1-2 недели. Есть мнение, что Google индексирует все страницы, а вот отображает в поисковой выдаче только наиболее «рейтинговые» из них

А вот Yandex изначально обращает внимание только на тот контент, который считает полезным

Libre Office

Как управлять поисковым роботом

Поисковая система скачивает информацию с сайта, учитывая robots.txt и sitemap. И именно там вы можете порекомендовать поисковику, что и как скачивать или не скачивать на вашем сайте.

Файл robots.txt

Это обычный текстовый файл, в котором указаны основные сведения — например, к каким поисковым роботам мы обращаемся (User-agent) и что запрещаем сканировать (Disallow).

Указания в robots.txt помогают поисковым роботам сориентироваться и не тратить свои ресурсы на сканирование маловажных страниц (например, системных файлов, страниц авторизации, содержимого корзины и т. д.). Например, строка Disallow:/admin запретит поисковым роботам просматривать страницы, URL которых начинается со слова admin, а Disallow:/*.pdf$ закроет им доступ к PDF-файлам на сайте.

Также в robots.txt стоит обязательно указать адрес карты сайта, чтобы указать поисковым роботам ее местоположение.

Чтобы проверить корректность robots.txt, загрузите его в специальную форму на странице Яндекс.Вебмастер или воспользуйтесь отдельным инструментом в .

Файл Sitemap

Еще один файл, который поможет вам оптимизировать процесс сканирования сайта поисковыми роботами ― это карта сайта (Sitemap). В ней указывают, как организован контент на сайте, какие страницы подлежат индексации и как часто информация на них обновляется.

Если на вашем сайте несколько страниц, поисковик наверняка обнаружит их сам. Но когда у сайта миллионы страниц, ему приходится выбирать, какие из них сканировать и как часто. И тогда карта сайта помогает в их приоритезации среди прочих других факторов.

Также сайты, для которых очень важен мультимедийный или новостной контент, могут улучшить процесс индексации благодаря созданию отдельных карт сайта для каждого типа контента. Отдельные карты для видео также могут сообщить поисковикам о продолжительности видеоряда, типе файла и условиях лицензирования. Карты для изображений ― что изображено, какой тип файла и т. д. Для новостей ― дату публикации. название статьи и издания.

Чтобы ни одна важная страница вашего сайта не осталась без внимания поискового робота, в игру вступают навигация в меню, «хлебные крошки», внутренняя перелинковка. Но если у вас есть страница, на которую не ведут ни внешние, ни внутренние ссылки, то обнаружить ее поможет именно карта сайта.

А еще в Sitemap можно указать:

- частоту обновления конкретной страницы — тегом <changefreq>;

- каноническую версию страницы ― атрибутом rel=canonical;

- версии страниц на других языках ― атрибутом hreflang.

Карта сайта также здорово помогает разобраться, почему возникают сложности при индексации вашего сайта. Например, если сайт очень большой, то там создается много карт сайта с разбивкой по категориям или типам страниц. И тогда в консоли легче понять, какие именно страницы не индексируются и дальше разбираться уже с ними.

Проверить правильность файла Sitemap можно на странице Яндекс.Вебмастер, а также в Google Search Console вашего сайта в разделе «Файлы Sitemap».

Итак, ваш сайт отправлен на индексацию, robots.txt и sitemap проверены, пора узнать, как прошло индексирование сайта и что поисковая система нашла на ресурсе.

Индексация сайта как Интернет ресурса

Первым шагом продвижения сайта в поисковой выдаче, это знакомство поисковиков с сайтом, как новым Интернет ресурсом. А проще, вы должны сообщить поисковикам ( Яндекс, Google, Bing, Mail.ru, Rambler) о появлении в сети вашего ресурса (сайта, блога, форума, портала). Для этого для начала, добавьте сайт в эти инструменты подтвердив свои права на него.

Практика показывает, что большая часть сайтов (с количеством страниц от нескольких десятков до нескольких сотен), как правило, не имеют проблем с индексацией сайта и его страниц поисковиками. Однако, есть, некоторые моменты, которые необходимо учесть, когда вы работаете над своим ресурсом.

Различия индексации сайта в Google и «Яндексе»

Основное различие поисковых систем «Гугл» и «Яндекс» заключается в региональной принадлежности. Если Yandex работает только в русскоязычной части Интернета, то Google является международным поисковиком. Свои системы поиска есть практически в каждой стране. В некоторых случаях региональные сервисы могут составлять серьезную конкуренцию «Гуглу» («Яндекс» в РФ, Seznam – в Чехии, Baidu – в КНР и т. д.). Подтверждением этого факта могут служить переговоры по вопросам выкупа сервиса Yandex компанией «Гугл», которые имели место в 2003 году. Пока такое поглощение не состоялось.

У каждой поисковой системы есть свои программы ботов, осуществляющие проверку сайтов на предмет релевантности и качества представленного на них контента. При этом стандарты работы таких роботов постоянно совершенствуются. Нужно отметить, что разработчики не открывают полностью суть алгоритмов индексации, поэтому специалисты постоянно анализируют поисковые программы и на основании имеющихся практических данных формируют определенные выводы.

Рекомендуемые статьи по данной теме:

- Внутренняя оптимизация сайта: пошаговый разбор

- Проверка robots.txt: типичные ошибки и их устранение

- Редирект с http на https: повышаем безопасность сайта

Требования, которые предъявляют «Гугл» и «Яндекс» к индексации сайтов, имеют много общего. Поэтому можно сформулировать некоторые универсальные рекомендации:

Нужно уделять больше внимание качеству контента (уникальность, полезность и грамотность)

Программные и орфографические ошибки четко отслеживаются ботами и снижают индекс авторитетности сайта.

Интернет-площадки должны иметь понятную структуру

Важно, чтобы они были удобными для пользователей и содержали важную и ценную информацию.

Следует качественно проработать страницы контактов и обратной связи, разместить портфолио и отзывы, а также описать имеющиеся достижения.

На сайте нужно разместить работающие исходящие ссылки.

Контент на интернет-площадках должен постоянно обновляться, а их функционал следует дорабатывать с учетом различных нововведений и инноваций. Все это учитывается поисковиками при ранжировании сайтов.

Поисковая система «Яндекса» имеет два робота – основной и быстрый (Orange). Первый осуществляет индексацию Сети в целом, а второй обеспечивает возможность быстрого поиска наиболее свежей и актуальной информации по запросу пользователя. Каждый робот имеет перечень данных, которые необходимо проиндексировать.

По мнению экспертов, «Яндекс» работает медленнее, чем «Гугл». Но при этом поисковая система Рунета индексирует полезные материалы и исключает из выдачи «лишние» результаты.

Преимущество «Гугла» заключается в его универсальности. «Яндекс» же развивается исключительно в русскоязычном Интернете (попытки выйти на другие рынки имели место, но пока не увенчались успехом).

Система Yandex ориентирована на поиск по запросам из ограниченного перечня регионов. Но именно региональный характер во многом определяет его успешность. В настоящее время «Гугл» и «Яндекс» занимают в русскоязычном Интернете примерно одинаковые ниши.

В интернет-пространстве других стран поисковая система Yandex не получила распространение, так как наиболее значимыми факторами поиска там выступают язык и местонахождение пользователя. На основании этих критериев и строится поисковая выдача «Гугла». В системе «Яндекс» индексация по языковым признакам не происходит. Несмотря на то, что этот поисковик определяет место нахождения пользователя, он не учитывает этот фактор при обработке запроса. Классифицировать сайты Рунета по регионам в зависимости от языка запроса не получается. «Яндекс» может настраивать поисковую выдачу исключительно по территориальному признаку, в чем и заключается уникальность этой системы.

Не так давно Yandex запустил новый инструмент – поиск «Андромеда». После этого поисковик предлагает определенные места в городах, дает возможность собирать коллекции пользователя, информирует о событиях из мира спорта, отмечает статус интернет-ресурсов особыми значками в зависимости от их благонадежности и популярности. Каким образом новый инструмент может влиять на индексацию, еще не совсем ясно.

Важным нововведением 2018 года является замена показателя ТИЦ (индекс цитирования) на ИКС (индекс качества сайта). Новый показатель необходимо учитывать при продвижении ресурса.