Файл robots txt для wordpress правильный и рабочий вариант для всех сайтов

Содержание:

- Как поисковики сканируют страницу

- Директивы robots.txt

- Область применения

- Операторы в robots.txt

- Что такое robots.txt и для чего он нужен

- Читайте также:

- Как создать файл robots.txt на своем сайте?

- Правильный Robots.txt для Bitrix

- Последние материалы из раздела «Автотовары»

- Приоритеты агентов пользователей

- Разблокировка Flash Player в Гугл Хром

- Для чего нужна проверка robots.txt

- Немного теории перед подключением роутера

- Лучшие практики robots.txt

- Каждую директиву прописывайте с новой строки

- Используйте маски для упрощения

- Используйте знак “$” для определения окончания URL адреса

- Используйте каждый user-agent не больше одного раза

- Будьте конкретными, чтобы избежать случайных ошибок

- Используйте комментарии, чтобы люди могли понимать ваш robots.txt

- Для каждого поддомена используйте отдельный файл robots.txt

- Как проводится проверка robots.txt Яндексом

- Заключение: советы Вебмастерам

Как поисковики сканируют страницу

Роботы-краулеры Яндекса и Google посещают страницы сайта, оценивают содержимое, добавляют новые ресурсы и информацию о страницах в индексную базу поисковика. Боты посещают страницы регулярно, чтобы переносить в базу обновления контента, отмечать появление новых ссылок и их доступность.

Зачем нужно сканирование:

- Собрать данные для построения индекса — информацию о новых страницах и обновлениях на старых.

- Сравнить URL в индексе и в списке для сканирования.

- Убрать из очереди дублирующиеся URL, чтобы не скачивать их дважды.

Боты смотрят не все страницы сайта. Количество ограничено

краулинговым бюджетом, который складывается из количества URL, которое может просканировать бот-краулер. Бюджета на объемный сайт может не хватить. Есть риск, что краулинговый бюджет уйдет на сканирование неважных или «мусорных» страниц, а чтобы такого не произошло, веб-мастеры направляют краулеров с помощью файла robots.txt.

Боты переходят на сайт и находят в корневом каталоге файл robots.txt, анализируют доступ к страницам и переходят к карте сайта —

Sitemap, чтобы сократить время сканирования, не обращаясь к закрытым ссылкам. После изучения файла боты идут на главную страницу и оттуда переходят в глубину сайта.

Какие страницы краулер просканирует быстрее:

-

Находятся ближе к главной.

Чем меньше кликов с главной ведет до страницы, тем она важнее и тем вероятнее ее посетит краулер. Количество переходов от главной до текущей страницы называется Click Distance from Index (DFI). -

Имеют много ссылок.

Если многие ссылаются на страницу, значит она полезная и имеет хорошую репутацию. Нормальным считается около 11-20 ссылок на страницу, перелинковка между своими материалами тоже считается. -

Быстро загружаются.

Проверьте скорость загрузки

инструментом, если она медленная — оптимизируйте код верхней части и уменьшите вес страницы.

Все посещения ботов-краулеров не фиксируют такие инструменты, как Google Analytics, но поведение ботов можно отследить в лог-файлах. Некоторые SEO-проблемы крупных сайтов можно решить с помощью

анализа лог-файлов который также поможет увидеть проблемы со ссылками и распределение краулингового бюджета.

Директивы robots.txt

Порядок включения директив:

|

<Директива><двоеточие><пробел><документ, к которому применяется директива> |

Для начала стоит сказать о том, какие директивы могут использоваться в файле robots.txt.

User-agent – указание робота, для которого составлен список директив ниже. Обязательная для robots.txt директива, которая указывается в начале файла.

- Основной User-agent поисковой системы Яндекс – Yandex (, которым можно указать отдельные директивы).

- Основной User-agent поисковой системы Google – Googlebot (список роботов Google, которым можно указать отдельные директивы).

- Если список директив указывается для всех возможных User-agent’ов, ставится – «*»

Disallow – директива запрета индексации документов. Можно указывать как каталог, так и часть названия документа, так и полный путь документа.

- При запрете индексации документа путь определяется от корня сайта (красная стрелка на рисунке 1).

- Для запрета индексации документов второго и далее уровней можно указывать полный путь документа, или перед адресом документа указывается знак «*» (синяя стрелка на рисунке 1).

- При запрете индексации каталога также будут запрещены к индексации все страницы, входящие в этот каталог (зеленая стрелка на рисунке 1).

- Можно запрещать для индексации документы, в url которых содержатся определенные символы (розовая стрелка на рисунке 1).

Рис. 1 Директива Disallow

Allow – директива разрешения индексации документов. Является директивой по умолчанию для всех документов на сайте, если не указано другое.

Используется для открытия к индексации документов (синие стрелки), которые по той или иной причине находятся в каталогах, закрытых от индексации (красные стрелки).

Можно открывать для индексации документы, в url которых содержатся определенные символы (синие стрелки).

Стоит обратить внимание на : «Директивы Allow и Disallow из соответствующего User-agent блока сортируются по длине префикса URL (от меньшего к большему) и применяются последовательно.»

Рис. 2 Директива Allow

Sitemap – директива для указания пути к файлу xml-карты сайта.

Если сайт имеет более 1 карты xml, допустимо указание нескольких путей.

|

User-agent: * Sitemap: http://site.ru/sitemap-1.xml Sitemap: http://site.ru/sitemap-2.xml |

Спецсимволы

- * — означает любую последовательность символов. Добавляется по умолчанию к концу каждой директивы (красная стрелочка на рисунке 3).

- $ — используется для отмены знака «*» на конце директивы (синяя стрелочка на рисунке 3).

- # — знак описания комментариев. Все что указывается справа от этого знака не будет учитываться роботами.

Рис. 3 Спецсимволы

Host – директива указания главного зеркала сайта. Учитывается только роботами Яндекса.

- Данная директива может склеить не только зеркала вида www.site.ru и site.ru но и другие сайты, в robots.txt которых указан соответствующий Host.

- Если зеркало доступно только по защищенному протоколу, указывается адрес с протоколом (https://site.ru). В других случаях протокол не указывается.

- Для настройки главного зеркала в поисковой системе Google используется функция «Настройки сайта» в Google Search Console.

Crawl-delay – директива указания минимального времени (в секундах) между окончанием загрузки одной страницы и началом загрузки следующей. Учитывается только роботами Яндекса. Директива используется, чтоб роботы поисковых систем не перегружали сайт.

Для ограничения времени между окончанием загрузки одной страницы и началом загрузки следующей в поисковой системе Google используется функция «Настройки сайта» в Google Search Console

Clean-param – директива используется для удаления параметров из url-адресов сайта. Учитывается только роботами Яндекса.

- Может использоваться для удаления меток отслеживания, фильтров, идентификаторов сессий и других параметров.

- Для правильной обработки меток роботами Google используется функция «Параметры URL» в Google Search Console.

Рис. 4 Clean-param

Область применения

Рабочая мощность насоса Малыш невелика, поэтому он не может использоваться для добычи воды из глубоких артезианских скважин. Зато отлично работает в колодцах и скважинах «на песок», а также может перекачивать воду из рек и озер, содержащую механические примеси.

Какие задачи можно решить с его помощью:

- Подъем воды с глубины до 40 метров;

- Её закачивание в систему водопровода дома и участка;

- Полив садовых насаждений;

- Откачивание воды из бассейнов, затопленных подвалов и погребов;

- Мойка автомобиля, дорожек и площадок, фасадов зданий и т.д.

Операторы в robots.txt

Прежде, чем мы перейдём к обзору директив, ознакомимся с дополнительными операторами. Про символ # мы поговорили выше. Кроме него вам могут потребоваться следующие операторы:

* сообщает, что допускается любое число символов или таковые отсутствуют;

$ поясняет, что находящийся перед ним символ является последним.

Директива User-agent

Адресует ваши команды определённому боту-поисковику. Именно с неё вы начинаете прописывать robots.txt.

(правила задаются для всех роботов Яндекса)

(правила задаются для всех роботов Google)

(правила задаются для всех поисковых систем)

Обращаю ваше внимание: когда поисковой робот обнаруживает своё имя после User-agent, то он не воспринимает все команды, которые вы зададите в блоке User-agent: *. И ещё, у отдельных поисковых систем существует целая группа ботов, команды для которых можно задавать в индивидуальном порядке

При этом блоки с рекомендациями для таких ботов разбиваются путём оставления пустой строки.

Поисковые роботы Google:

Googlebot – основной бот системы;

Googlebot-Image – обрабатывает изображения;

Googlebot-Video – отслеживает видео-контент;

Googlebot-Mobile – работает со страницами для мобильных девайсов;

Adsbot-Google – анализирует качество рекламы на веб-страницах для персональных компьютеров;

Googlebot-News – определяет веб-страницы, которые следует внести в Новости Google.

Поисковые роботы Yandex:

YandexBot – основной бот системы;

YandexImages – обрабатывает изображения;

YandexNews – определяет веб-страницы для добавления в Яндекс.Новости;

YandexMedia – отслеживает мультимедиа контент;

YandexMobileBot – работает со страницами для мобильных девайсов.

Директива Disallow

Самая популярная команда – выдаёт запрет на индексацию страниц.

Примеры:

(закрытие доступа ко всему веб-ресурсу)

(закрытие доступа к панели администратора)

(закрытие доступа на обработку документов заданного типа)

Директива Allow

Даёт право обрабатывать поисковикам заданные вами веб-страницы. Это особенно актуально в процессе ведения техработ на сайте. Например, вы модернизируете веб-ресурс, но каталог с товарами не подлежит изменениям. Вы закрываете доступ к своему сайту, а ботов направляете только к нужному вам разделу.

Пример:

Директива Host

До недавнего времени применялась для показа роботам Яндекса основного зеркала веб-сайта – с www или без. Весной 2018 г. российская ИТ-компания проинформировала пользователей, что директива заменяется на редирект 301 – универсальный метод для всех работающих поисковиков, который указывает на основной сайт.

На сегодняшний день эта команда бесполезна. Но если она проставлена в файле, то ничего страшного – поисковые боты её просто игнорируют.

Директива Sitemap

Предназначена для указания пути к Карте вашего ресурса. По-хорошему, sitemap.xml должен храниться в корне веб-сайта. В случае, когда путь отличается, эта команда позволяет найти поисковикам Карту.

Директива Clean-param

Её задача – пояснить боту, что нет необходимости в индексировании страницы с определёнными параметрами. Это относится к динамическим ссылкам, ведь они периодически формируются в ходе работы веб-сайта и образуют дубли – то есть одинаковая страница становится доступна на нескольких адресах. Тогда применяется «ref» – параметр, позволяющий выявить источник ссылки.

Пример:

Результат:

Таким образом поисковик сведёт все URL к одной странице. Она будет участвовать в поисковой выдаче при условии её наличия на веб-сайте:

Директива Crawl-Delay

Команда предназначена, чтобы уведомить бота-поисковика о продолжительности загрузки страницы (в секундах). Она позволяет снизить нагрузку на веб-ресурс. Это актуально, когда веб-сайт размещён на слабом сервере.

Выглядит это так:

(вы уведомили поисковика, что можно скачивать данные каждые 3.5 секунд)

Что такое robots.txt и для чего он нужен

Robots.txt — это обычный текстовый файл с расширением .txt, который содержит директивы и инструкции индексирования сайта, его отдельных страниц или разделов для роботов поисковых систем.

Давайте рассмотрим самый простой пример содержимого robots.txt, которое разрешает поисковым системам индексировать все разделы сайта:

User-agent: * Allow: /

Данная инструкция дословно говорит: всем роботам, читающим данную инструкцию (User-agent: *) разрешаю индексировать весь сайт (Allow: /).

Зачем все эти сложности с инструкциями для роботов, и почему нельзя открывать сайт для индексации полностью?

Представьте, что вы поисковый робот, которому нужно просмотреть миллиарды страниц по всем интернету, потом определить для каждой страницы запросы, которым они могут соответствовать и в конце проранжировать эту массу в поисковой выдаче. Согласитесь, задача не из легких. Для работы поисковых алгоритмов используются колоссальные ресурсы, которые, разумеется, ограничены.

Если помимо страниц, которые содержат полезный контент, и которые по задумке владельца сайта должны участвовать в выдаче, роботу придется просматривать еще кучу технических страниц, которые не представляют никакой ценности для пользователей, его ресурсы будут тратиться впустую. Вы только представьте, что только один единственный сайт может генерировать тысячи страниц результатов поиска по сайту, дублирующихся страниц или страниц, не содержащих контента вообще. А если этот объем масштабировать на всю сеть, то получатся гигантские цифры и соответствующие ресурсы, которые необходимо тратить поисковикам.

Наличие огромного количества бесполезного контента на вашем сайте может негативно сказаться на его представлении в поиске. Как бы вы отнеслись к человеку, который дал вам мешок орехов, но внутри оказалась только скорлупа и всего 2-3 орешка? Не трудно представить и позицию поисковиков при аналогии данной ситуации с вашим сайтом.

Кроме того, существует такое понятие, как краулинговый бюджет. Условно, это объем страниц, который может участвовать в поисковой выдаче от одного сайта. Этот объем, естественно, ограничен, но по мере роста проекта и повышения его качества, краулинговый бюджет может увеличиваться, но сейчас не об этом. Главное идея в том, в выдаче должны участвовать только страницы, которые содержат полезный контент, а весь технический «мусор» не должен засорять выдачу поисковым спамом.

Читайте также:

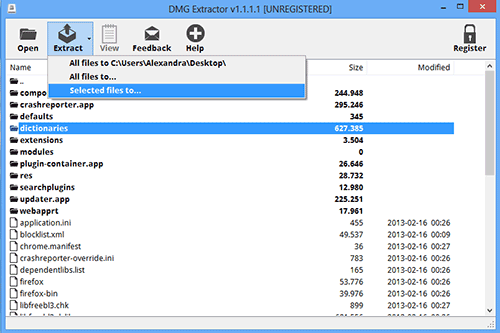

Как создать файл robots.txt на своем сайте?

Для того, чтобы создать файл robots.txt, вам нужно открыть любой текстовый редактор, например, Блокнот, MS Word, SublimeText, NotePad++ и т.п. Прописать необходимые инструкции для вашего сайта и сохранить файл в формате .txt.

Далее данный файл необходимо загрузить в корневую директорию вашего сайта. Корневая директория, это папка, как правило, с названием вашего сайта в которой находятся файлы вашей CMS и индексный файл index.html. Загрузить файл robotx.txt на сервер можно с помощью панели управления сервером (напр. ISPmanager, Cpannel), с помощью FTP-клиента (напр. FileZilla, TotalCommander), через консоль, либо через административную панель сайта, если CMS позволяет это сделать.

Некоторые системы управления сайтами имеют встроенный функционал, который позволяет создать robots.txt из админки сайта, либо с помощью дополнительных плагинов или модулей. Каким способом создавать robots.txt — нет абсолютно никакой разницы. Проверить корректность и доступность вашего файла robots вы можете с помощью сервиса в Яндекс.Вебмастере.

Правильный Robots.txt для Bitrix

Код для Robots, который прописан ниже, является базовым, универсальным для любого сайта на битриксе. В то же время, нужно понимать, что у вашего сайта могут быть свои индивидуальные особенности, и этот файл потребуется скорректировать в вашем конкретном случае.

User-agent: * # правила для всех роботов Disallow: /cgi-bin # папка на хостинге Disallow: /bitrix/ # папка с системными файлами битрикса Disallow: *bitrix_*= # GET-запросы битрикса Disallow: /local/ # папка с системными файлами битрикса Disallow: /*index.php$ # дубли страниц index.php Disallow: /auth/ # авторизация Disallow: *auth= # авторизация Disallow: /personal/ # личный кабинет Disallow: *register= # регистрация Disallow: *forgot_password= # забыли пароль Disallow: *change_password= # изменить пароль Disallow: *login= # логин Disallow: *logout= # выход Disallow: */search/ # поиск Disallow: *action= # действия Disallow: *print= # печать Disallow: *?new=Y # новая страница Disallow: *?edit= # редактирование Disallow: *?preview= # предпросмотр Disallow: *backurl= # трекбеки Disallow: *back_url= # трекбеки Disallow: *back_url_admin= # трекбеки Disallow: *captcha # каптча Disallow: */feed # все фиды Disallow: */rss # rss фид Disallow: *?FILTER*= # здесь и ниже различные популярные параметры фильтров Disallow: *?ei= Disallow: *?p= Disallow: *?q= Disallow: *?tags= Disallow: *B_ORDER= Disallow: *BRAND= Disallow: *CLEAR_CACHE= Disallow: *ELEMENT_ID= Disallow: *price_from= Disallow: *price_to= Disallow: *PROPERTY_TYPE= Disallow: *PROPERTY_WIDTH= Disallow: *PROPERTY_HEIGHT= Disallow: *PROPERTY_DIA= Disallow: *PROPERTY_OPENING_COUNT= Disallow: *PROPERTY_SELL_TYPE= Disallow: *PROPERTY_MAIN_TYPE= Disallow: *PROPERTY_PRICE= Disallow: *S_LAST= Disallow: *SECTION_ID= Disallow: *SECTION= Disallow: *SHOWALL= Disallow: *SHOW_ALL= Disallow: *SHOWBY= Disallow: *SORT= Disallow: *SPHRASE_ID= Disallow: *TYPE= Disallow: *utm*= # ссылки с utm-метками Disallow: *openstat= # ссылки с метками openstat Disallow: *from= # ссылки с метками from Allow: */upload/ # открываем папку с файлами uploads Allow: /bitrix/*.js # здесь и далее открываем для индексации скрипты Allow: /bitrix/*.css Allow: /local/*.js Allow: /local/*.css Allow: /local/*.jpg Allow: /local/*.jpeg Allow: /local/*.png Allow: /local/*.gif # Укажите один или несколько файлов Sitemap Sitemap: http://site.ru/sitemap.xml Sitemap: http://site.ru/sitemap.xml.gz # Укажите главное зеркало сайта, как в примере ниже (с WWW / без WWW, если HTTPS # то пишем протокол, если нужно указать порт, указываем). Команда стала необязательной. Ранее Host понимал # Яндекс и Mail.RU. Теперь все основные поисковые системы команду Host не учитывают. Host: www.site.ru

В примере я не добавляю правило Crawl-Delay, т.к. в большинстве случаев эта директива не нужна. Однако если у вас крупный нагруженный ресурс, то использование этой директивы поможет снизить нагрузку на сайт со стороны роботов Яндекса, Mail.Ru, Bing, Yahoo и других (Google не учитывает). Подробнее про это читайте в статье Robots.txt.

Последние материалы из раздела «Автотовары»

Приоритеты агентов пользователей

Для отдельного поискового робота имеет силу только одна группа. Он должен найти ту, в которой наиболее конкретно указан агент пользователя из числа подходящих. Все остальные группы будут пропущены. В обозначении агента пользователя учитывается регистр. Весь неподходящий текст игнорируется. Например, и аналогичны варианту . Порядок групп в файле robots.txt не имеет значения.

Если определенному агенту пользователя соответствует несколько групп, то все относящиеся к нему правила из всех групп объединяются в одну.

Пример 1

Предположим, что имеется следующий файл robots.txt:

user-agent: googlebot-news

(group 1)

user-agent: *

(group 2)

user-agent: googlebot

(group 3)

Сведения о том, какую группу выберут разные поисковые роботы, приведены в таблице ниже.

| Соответствие групп роботам | |

|---|---|

| Googlebot News | Выбирается группа 1, в которой конкретнее всего указан подходящий агент пользователя. Остальные игнорируются. |

| Googlebot (веб-поиск) | Выбирается группа 3. |

| Googlebot Images | Выбирается группа 3, поскольку нет отдельной группы с конкретным указанием элемента . |

| Googlebot News (при сканировании изображений) | Выбирается группа 1, поскольку в данном случае изображения будут сканироваться именно роботом Googlebot News. |

| Otherbot (веб-поиск) | Выбирается группа 2. |

| Otherbot (для новостей) | Выбирается группа 2. Даже если имеется запись для схожего робота, она недействительна без точного соответствия. |

Пример 2

Предположим, что имеется следующий файл robots.txt:

user-agent: googlebot-news

disallow: /fish

user-agent: *

disallow: /carrots

user-agent: googlebot-news

disallow: /shrimp

Поисковые роботы объединят группы, относящиеся к одному агенту пользователя, следующим образом:

user-agent: googlebot-news

disallow: /fish

disallow: /shrimp

user-agent: *

disallow: /carrots

Дополнительная информация приведена в Справочном центре.

Разблокировка Flash Player в Гугл Хром

Для чего нужна проверка robots.txt

Иногда в результаты поиска система включает ненужные страницы вашего Интернет-ресурса, в чем нет необходимости. Может показаться, что ничего плохого в большом количестве страниц в индексе поисковой системы нет, но это не так:

- На лишних страницах пользователь не найдет никакой полезной информации для себя. С большей долей вероятности он и вовсе не посетит эти страницы либо задержится на них недолго;

- В выдаче поисковика присутствуют одни и те же страницы, адреса которых различны (то есть контент дублируется);

- Поисковым роботам приходится тратить много времени, чтобы проиндексировать совершенно ненужные страницы. Вместо индексации полезного контента они будут бесполезно блуждать по сайту. Поскольку индексировать полностью весь ресурс робот не может и делает это постранично (так как сайтов очень много), то нужная информация, которую вы бы хотели получить после ведения запроса, возможно, будет найдена не очень быстро;

- Очень сильно нагружается сервер.

В связи с этим является целесообразным закрытие доступа поисковым роботам к некоторым страницам веб-ресурсов.

Какие же файлы и папки можно запретить индексировать:

- Страницы поиска. Это спорный пункт. Иногда использование внутреннего поиска на сайте необходимо, для того чтобы создать релевантные страницы. Но делается это не всегда. Зачастую результатом поиска становится появление большого количества дублированных страниц. Поэтому рекомендуется закрыть страницы поиска для индексации.

- Корзина и страница, на которой оформляют/подтверждают заказ. Их закрытие рекомендовано для сайтов онлайн-торговли и других коммерческих ресурсов, использующих форму заказа. Попадание этих страниц в индекс поисковых систем крайне нежелательно.

- Страницы пагинации. Как правило, для них характерно автоматическое прописывание одинаковых мета-тегов. Кроме того, их используют для размещения динамического контента, поэтому в результатах выдачи появляются дубли. В связи с этим пагинация должна быть закрыта для индексации.

- Фильтры и сравнение товаров. Закрывать их нужно онлайн-магазинам и сайтам-каталогам.

- Страницы регистрации и авторизации. Закрывать их нужно в связи с конфиденциальностью вводимых пользователями при регистрации или авторизации данных. Недоступность этих страниц для индексации будет оценена Гуглом.

- Системные каталоги и файлы. Каждый ресурс в Интернете состоит из множества данных (скриптов, таблиц CSS, административной части), которые не должны просматриваться роботами.

Закрыть файлы и страницы для индексации поможет файл robots.txt.

Рекомендуемые статьи по данной теме:

- Проверка тИЦ сайта: 3 способа

- Внутренняя оптимизация сайта: пошаговый разбор

- Файл htaccess: применение, включение, настройка

robots.txt – это обычный текстовый файл, содержащий инструкции для поисковых роботов. Когда поисковый робот оказывается на сайте, то в первую очередь занимается поиском файла robots.txt. Если же он отсутствует (или пустой), то робот будет заходить на все страницы и каталоги ресурса (в том числе и системные), находящиеся в свободном доступе, и пытаться провести их индексацию. При этом нет гарантии, что будет проиндексирована нужная вам страница, поскольку он может и не попасть на нее.

robots.txt позволяет направлять поисковые роботы на нужные страницы и не пускать на те, которые индексировать не следует. Файл может инструктировать как всех роботов сразу, так и каждого в отдельности. Если страницу сайта закрыть от индексации, то она никогда не появится в выдаче поисковой системы. Создание файла robots.txt является крайне необходимым.

Местом нахождения файла robots.txt должен быть сервер, корень вашего ресурса. Файл robots.txt любого сайта доступен для просмотра в Сети. Чтобы увидеть его, нужно после адреса ресурса добавить /robots.txt.

Как правило, файлы robots.txt различных ресурсов отличаются друг от друга. Если бездумно скопировать файл чужого сайта, то при индексации вашего поисковыми роботами возникнут проблемы. Поэтому так необходимо знать, для чего нужен файл robots.txt и инструкции (директивы), используемые при его создании.

Оставить заявку

Вас также может заинтересовать: Что делать, если упала посещаемость сайта

Немного теории перед подключением роутера

Маршрутизатор (он же роутер) – это прибор, имеющий отдельную флэш-память, в которой размещена индивидуальная операционная система. По этой причине при подключении он не будет отображён компьютером в диспетчере устройств.

Беспроводные вай-фай маршрутизаторы от Ростелеком могут функционировать благодаря наличию основного устройства (например, домашнего компьютера). При этом используется специальная SIM-карта от Ростелеком, по которой в соответствии с выбранным и оплаченным тарифом будет передаваться определённый объём интернет-трафика.

Маршрутизатор начинает функционировать только после подключения к питанию (аккумулятору, электросети). Первичная настройка при подключении WiFi роутера Ростелеком к принимающему устройству осуществляется при помощи кабеля. Прежде всего, потребуется убедиться в стабильной работе интернета. Далее можно заняться настройкой беспроводного подключения.

Подключённый к питанию маршрутизатор сразу же начинает осуществлять раздачу собственного сигнала. Даже при отсутствии сетевого кабельного соединения на панели устройства светится вай-фай индикатор. Наименование включённого оборудования отображается в перечне доступных сетей на расположенных в пределах квартиры (дома) мобильных или планшетах.

Однако неправильная настройка или неверное подключение вай-фай роутера Ростелеком могут воспрепятствовать нормальной работе интернета.

Лучшие практики robots.txt

Чтобы избежать распространённых ошибок, следуйте этим правилам.

Каждую директиву прописывайте с новой строки

Каждая директива должна быть прописана на новой строке. Иначе поисквые системы её не поймут.

Плохо:

User-agent: * Disallow: /directory/ Disallow: /another-directory/

Хорошо:

User-agent: * Disallow: /directory/ Disallow: /another-directory/

Используйте маски для упрощения

Маски (*) можно использовать не только для определения всех user-agent, но и для шаблонов URL адресов при объявлении директив. Например, если вы хотите запретить поисковым системам доступ к URL-адресам категорий товаров с параметрами на вашем сайте, вы можете перечислить их следующим образом:

User-agent: * Disallow: /products/t-shirts? Disallow: /products/hoodies? Disallow: /products/jackets? …

Но это не очень эффективно. Было бы использовать маску, как здесь:

User-agent: * Disallow: /products/*?

В этом примере поисковым системам запрещается сканировать все URL-адреса в подпапке /product/ со знаком вопроса. Другими словами, любые URL с параметрами категории товаров.

Используйте знак “$” для определения окончания URL адреса

Используйте знак “$” чтобы указать окончание URL адреса. Например, если вы хотите запретить поисковым системам доступ ко всем файлам .pdf на вашем сайте, ваш файл robots.txt может выглядеть следующим образом:

User-agent: * Disallow: /*.pdf$ В этом примере у поисковых систем нет доступа к URL-адресам, которые заканчиваются на .pdf. Это означает, что они не могут получить доступ к /file.pdf, но они могут получить доступ к /file.pdf?id=68937586, потому что он не заканчивается на ".pdf".

Используйте каждый user-agent не больше одного раза

Если вы указали один и тот же user-agent несколько раз, Google поймёт. Он просто объединит все правила из разных мест в одно и будет следовать им всем. Например, если в вашем файле robots.txt были следующие user-agent и директивы…

User-agent: Googlebot Disallow: /a/ User-agent: Googlebot Disallow: /b/

… Googlebot не будет сканировать ни одну из подпапок.

Тем не менее, не стоит прописывать user-agent больше одного раза, потому что так вы будете меньше путаться. Другими словами, если всё будет упорядочено и просто, то вы не будете совершать критических ошибок.

Будьте конкретными, чтобы избежать случайных ошибок

Если дать нечёткие инструкции при составлении директив, вы можете легко совершить ошибку. Это может иметь катастрофические последствия для вашего SEO. Предположим, что у вас есть мультиязычный сайт и вы работаете над немецкой версией, которая будет доступна в подпапке /de/.

Поскольку она ещё не полностью готова, вы хотите закрыть поисковым системам доступ к ней.

Файл robots.txt, который вы видите ниже запрещает поисковым системам заходить в эту подпапку и сканировать что-либо в ней:

User-agent: * Disallow: /de

Но вы также запретите сканировать все страницы и файлы, которые начинаются на.

Например:

В данном случае решение простое: добавить в конце косую черту.

User-agent: * Disallow: /de/

Используйте комментарии, чтобы люди могли понимать ваш robots.txt

Комментарии помогают разработчикам понимать ваш файл robots.txt и, возможно, даже вам самим в будущем. Чтобы добавить комментарий, начните строку со знака хеша (#).

# This instructs Bing not to crawl our site. User-agent: Bingbot Disallow: /

Роботы будут игнорировать все строки, которые начинаются с этого символа.

Для каждого поддомена используйте отдельный файл robots.txt

Robots.txt контролирует сканирование только на поддомене, где он размещен. Если вы хотите контролировать сканирование на другом поддомене, вам понадобится отдельный файл robots.txt.

Например, если ваш основной сайт находится на domain.com, а ваш блог — на blog.domain.com, вам понадобятся два файла robots.txt. Один должен идти в корневой каталог основного домена, а другой — в корневой каталог блога.

Как проводится проверка robots.txt Яндексом

После начала проверки анализатор разбирает каждую строку содержимого поля «Текст robots.txt» и анализирует директивы, которые он содержит. Кроме того, вы узнаете, будет ли робот обходить страницы из поля «Список URL».

Составлять файл robots.txt, подходящий для вашего ресурса, можно редактированием правил. Не забывайте, что сам файл ресурса при этом остается неизменным. Для вступления изменений в силу понадобится самостоятельная загрузка новой версии файла на сайт.

При проверке директив разделов, которые предназначены для робота Яндекса (User-agent: Yandex или User-agent:*), анализатор руководствуется правилами использования robots.txt. Остальные разделы проверяются в соответствии с требованиями стандарта. Когда анализатор разбирает файл, то выводит сообщение о найденных ошибках, предупреждает, если в написании правил есть неточности, перечисляет, какие части файла предназначены для робота Яндекса.

Анализатор может посылать сообщения двух типов: ошибки и предупреждения.

Сообщение об ошибке выводится, если какая-либо строка, секция или весь файл не могут быть обработаны анализатором вследствие наличия серьезных синтаксических ошибок, которые допустили при составлении директив.

В предупреждении, как правило, сообщается об отклонении от правил, исправление которого анализатором невозможно, или о наличии потенциальной проблемы (ее может и не оказаться), причина которой – случайная опечатка или неточное составленные правила.

Сообщение об ошибке «Этот URL не принадлежит вашему домену» говорит о том, что в списке URL содержится адрес одного из зеркал вашего ресурса, к примеру, http://example.com вместо http://www.example.com (формально эти URL различны). Нужно, чтобы подлежащие проверке адреса относились к сайту, файл robots.txt которого анализируется.

Вас также может заинтересовать: Файл htaccess: применение, включение, настройка

Заключение: советы Вебмастерам

Совет #1

Если ваш сайт не индексируется поисковыми системами, или его страницы начали массово пропадать из поисковой выдачи, первым делом необходимо проверить файл robots.txt на предмет запрета индексации сайта. При необходимости снимите запрет на полезные страницы, которые должны участвовать в выдаче.

Если файл robots.txt не запрещает индексирование сайта, проверьте содержимое мета-тегов в head вашего сайта, адресованных поисковым роботам

Обратите внимание на наличие на вашем сайте следующих тегов:

<meta name="robots" content="noindex"/> — запрещает индексировать содержимое страницы <meta name="robots" content="nofollow"/> — запрещает переходить по ссылкам на странице <meta name="robots" content="none"/> — запрещает переходить по ссылкам и индексировать содержимое страницы <meta name="robots" content="noindex, nofollow"/> — аналогичен предыдущему тегу

Наличие данных тегов может негативно повлиять на представление вашего сайта в поисковых системах.

Совет #2

Хотя бы 1 раз в 2-3 недели заглядывайте в Яндекс Вебмастер в разделы «Индексирование — Статистика обхода» и «Индексирование — Страницы в поиске». Отслеживайте страницы, которые обходит поисковый робот на вашем сайте.

Если робот обходит технические страницы, или страницы, которые отвечают редиректом, их следуют запретить директивой Disallow в robots.txt. Таким образом вы сузите объем страниц, который необходимо обойти поисковому роботу и повысите эффективность индексации своего сайта.

Аналогична ситуация с разделом «Страницы в поиске». С его помощью вы можете не только отследить документы, которые больше не участвуют в поиске, но и проверить свой сайт на предмет наличия поискового спама. Если в данном разделе вы также найдете технические страниц, либо сервисные страницы с параметрами, которые не должны принимать участие в ранжировании, добавьте запрет на их обход в robots.txt.

Заключение

Файл robots.txt является одним из важнейших инструментов SEO-оптимизации. Через него можно напрямую влиять на индексирование абсолютно любых страниц и разделов сайта. Грамотно составленный robots.txt поможет вам сэкономить место в ограниченном краулинговом бюджете, избавит поисковые роботы от переобхода сотен ненужных технических страниц, избавит выдачу от поискового спама, а ваш сервер от излишней нагрузки. Создавайте robots.txt с умом!